程序員12小時驚魂記 凌晨遷移數據出大事故

凌晨三點,當城市已陷入沉睡,科技園區的某棟大樓里,技術開發部的燈光依舊通明。程序員小李和他的團隊正在進行一項關鍵的數據遷移任務。這次遷移涉及到公司核心業務系統的數據庫,預計耗時四小時,為了最小化對用戶的影響,他們選擇了這個流量最低的時間窗口。誰也沒有料到,一場持續12小時的技術驚魂即將拉開序幕。

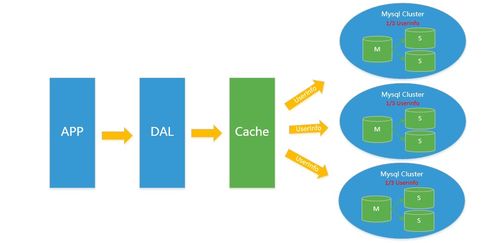

遷移初期一切順利。腳本平穩運行,數據如流水般從舊集群向新集群轉移。但就在進度達到70%時,監控系統突然發出刺耳的警報:新集群的磁盤I/O異常飆升,主數據庫節點響應延遲急劇上升,最終徹底失去響應。整個遷移進程戛然而止。

團隊瞬間陷入緊張。初步排查發現,是新集群的某個存儲配置與舊系統不兼容,導致數據寫入時產生了無法預料的鎖沖突,進而引發雪崩效應。更糟糕的是,由于回滾方案預設不足,他們發現自己被困在了‘中間狀態’——舊數據已部分破壞,新數據又無法完整接替。

凌晨四點半,危機升級。受影響的業務系統開始出現零星錯誤報告。一小時后,錯誤報告如潮水般涌來,客戶端APP頻繁閃退,網頁端顯示‘服務不可用’。這意味著,公司的核心服務正在對用戶失效。壓力從技術層面蔓延至業務和公關層面。

時間一分一秒過去,團隊嘗試了多種搶救方案:從備份恢復、手動修補數據到嘗試啟用災備系統,但都因數據的一致性問題或新的依賴沖突而失敗。每一次嘗試都伴隨著希望與失望的劇烈起伏。作為負責人的小李,額頭沁滿了汗珠,他不僅要解決技術難題,還要不斷向被電話驚醒、焦急詢問的上級解釋進展。

清晨七點,天已蒙蒙亮。在連續嘗試了數個復雜方案未果后,團隊決定采用一個大膽但風險極高的計劃:利用凌晨遷移開始時抓取的邏輯快照,結合故障期間產生的二進制日志,嘗試在另一個全新的、配置經過嚴格驗證的集群上‘重放’并重構整個數據庫。這相當于在高速行駛中更換輪胎,且不容有失。

接下來的四個小時是意志與技術的雙重考驗。開發、運維、網絡工程師緊密協作,編寫補救腳本,監控每一行日志,手動驗證關鍵數據的一致性。期間經歷了網絡短暫波動、中間件意外超時等數次小危機,都被團隊逐一化解。

上午十一點,經過近八小時的鏖戰,新重構的集群終于通過了所有核心業務邏輯的驗證測試。在請示管理層并獲得授權后,團隊謹慎地將流量逐步切換至新系統。監控圖表上的錯誤率曲線開始陡峭下降,最終歸零。服務全面恢復!

當確認所有系統運行平穩,已是下午三點。歷時整整十二個小時。這場因網絡技術開發中配置疏忽和預案不充分引發的重大事故終于落幕。事后復盤會上,除了技術層面的教訓——如更嚴格的預生產環境測試、更完善的回滾與災備機制,團隊更深刻地認識到,在追求開發效率的對運維復雜性和風險邊界的敬畏同等重要。這次驚魂記,用十二個小時的極限壓力,為他們上了關于系統韌性、團隊協作與風險管理的沉重一課。

如若轉載,請注明出處:http://m.dgcnd.cn/product/49.html

更新時間:2026-01-07 04:20:27